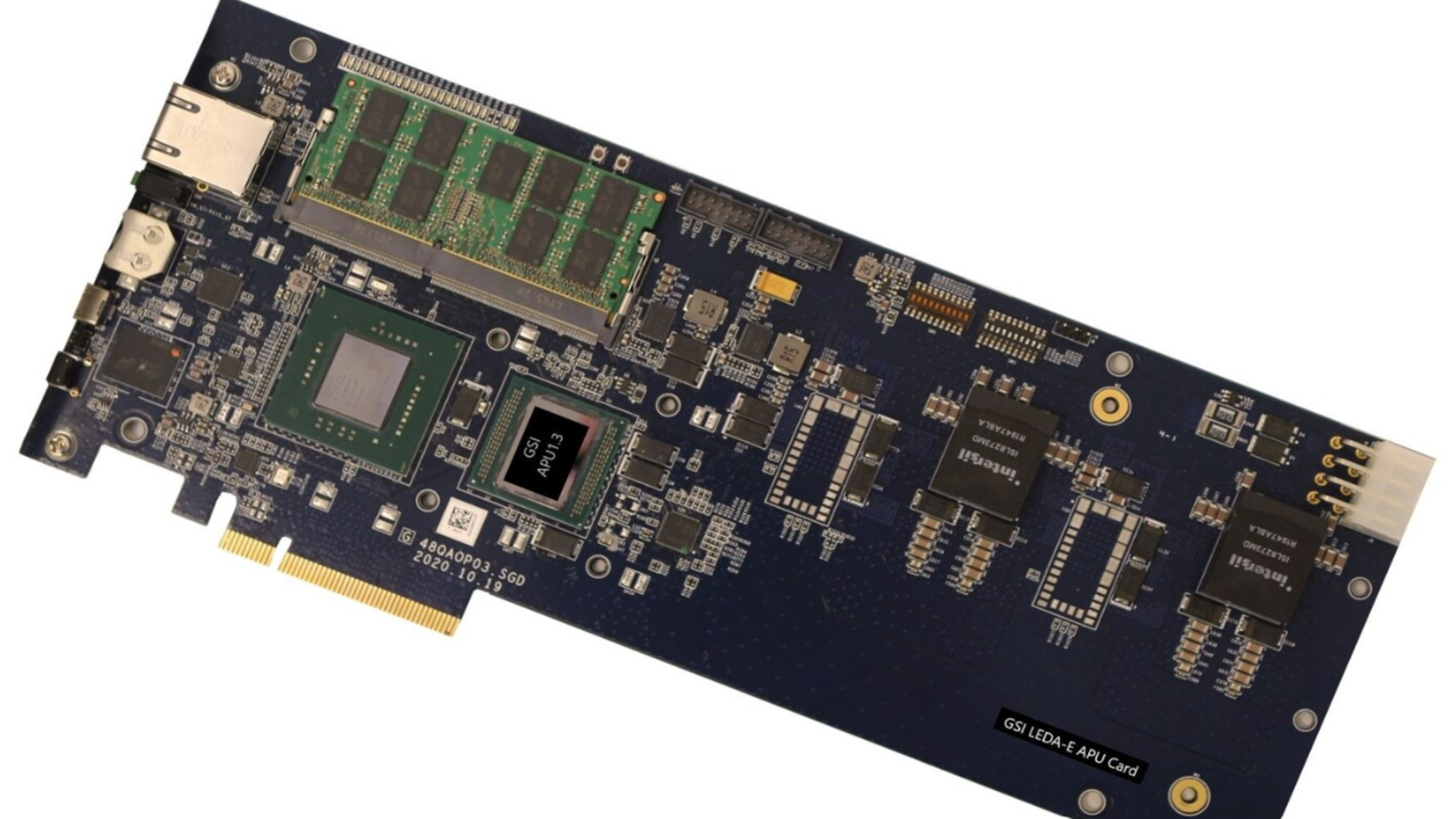

A GSI Technology está impulsionando uma nova abordagem para o processamento de inteligência artificial, que coloca a computação diretamente na memória. Um estudo da Cornell University destaca essa arquitetura, conhecida como unidade de processamento associativo (APU). O objetivo é superar as limitações de desempenho e eficiência, sugerindo um desafio à supremacia das GPUs usadas em ferramentas de IA e data centers. Publicada no periódico ACM e apresentada na conferência Micro ’25, a pesquisa da Cornell avaliou o Gemini-I APU da GSI em comparação com CPUs e GPUs de ponta, incluindo a A6000 da Nvidia, utilizando cargas de trabalho de geração aumentada por recuperação (RAG). Os testes foram realizados em conjuntos de dados de 10 a 200GB, simulando condições realistas de inferência de IA. Ao realizar a computação dentro da RAM estática, o APU reduz a constante troca de dados entre o processador e os sistemas de memória, uma importante fonte de perda de energia e latência em arquiteturas de GPU convencionais. Os resultados indicaram que o APU conseguiu alcançar a taxa de transferência de uma GPU, consumindo muito menos energia. A GSI relatou que seu APU usou até 98% menos energia que uma GPU padrão e completou tarefas de recuperação até 80% mais rápido que CPUs comparáveis. Essa eficiência pode torná-lo atraente para dispositivos de borda, como drones, sistemas IoT e robótica, bem como para uso em defesa e aeroespacial, onde as restrições de

APU da GSI Desafia GPUs da Nvidia: A Revolução da IA Chega com Computação na Memória!

Chips de computação na memória como o APU da GSI podem transformar o hardware de IA, mas a escalabilidade ainda é uma questão.

1

visualizações

0

curtidas

0

comentários

0 Comentários

Entre para comentar

Use sua conta Google para participar da discussão.

Política de Privacidade

Carregando comentários...

Escolha seus interesses

Receba notificações personalizadas